En estos días, la empresa X, liberó de pago su aplicación Grok, un chat similar a Chat GPT (Microsoft) o Gemini (Google), cuya función es ser un “asistente humorístico de IA para X”. Esto que parece divertido es, en realidad, una declaración política/comercial del dueño de la plataforma, Elon Musk, para competir contra otras grandes tecnológicas, que desarrollaron asistentes de I.A., destacando un aspecto diferenciador con su competencia: el humor e ingenio. Pero, ¿puede colarse la desinformación generada por I.A. generativa?

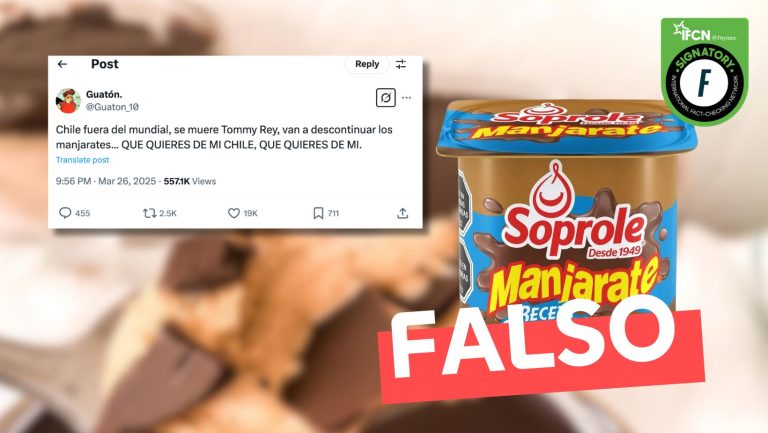

Detrás de esto existe un ánimo de entregar una herramienta sin muchos límites o bordes éticos, donde una persona con tan solo escribir un prompt de cuatro palabras como “Boric y Maduro abrazados”, genera una imagen muy fiel, casi perfecta, de ambos mandatarios entrelazados y demostrando un cariño, que en la realidad factual, es inexistente. Las imágenes que Grok genera son completamente falsas, creadas con inteligencia artificial generativa. Sin embargo, ante los ojos de cualquier persona que no sepa un poco más sobre tecnología, o no alcance a leer la pequeña marca de agua que se autogenera en el costado derecho de la imagen, será muy difícil de cuestionar, de alertar, creando de este modo un contenido de desinformación, amparado en la libertad, el humor y el ingenio.

No se puede realizar el mismo ejercicio en los chats de la competencia, ya que se bloquean los contenidos ofensivos o que puedan promover desinformación. Tienen mayores capas de control para evitar un uso malintencionado o poco ético de estas herramientas. Esto lo sabe muy bien Elon Musk y por eso libera esta restricción y entrega el límite o autocontrol a las personas. ¿Qué podría salir mal?

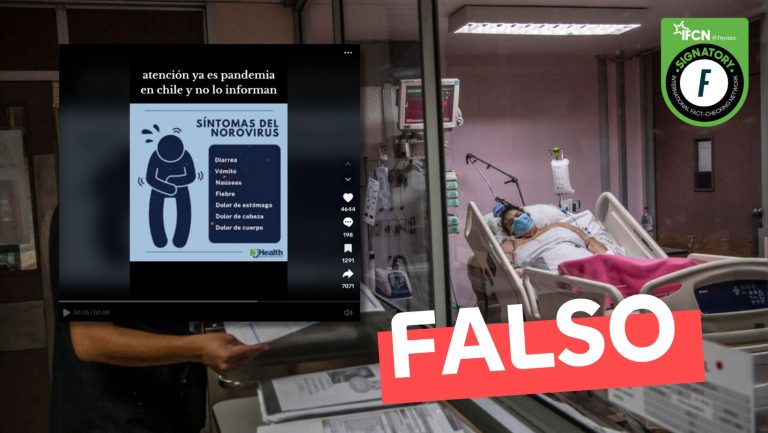

El problema de la I.A. generativa es que ya está aquí, es parte de nuestra convivencia más habitual, pero parece no preocuparnos lo suficiente, tal como tampoco nos importa mucho la crisis climática, la crisis económica, la crisis de confianza y, en realidad, lo que hacemos es tratar de convivir mitigando efectos para todas estas crisis, incluyendo esta crisis de la desinformación. Cuando una crisis se instala en la cotidianeidad, pareciera que somos parte de ella desde su inicio y ya no sabemos más distinguir cuando empezó y tampoco cuando terminará.

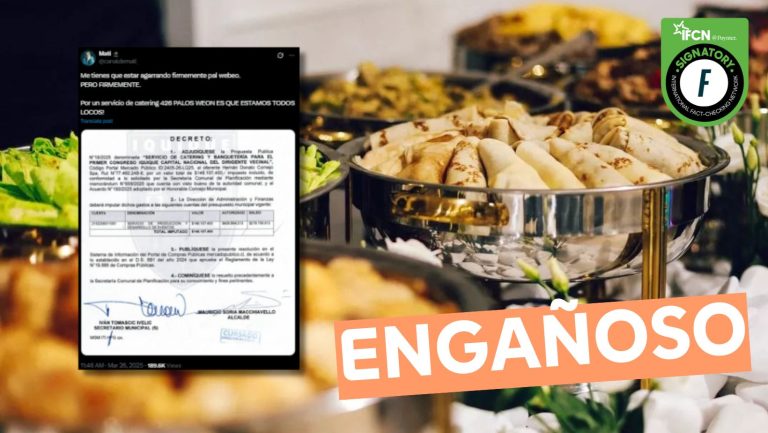

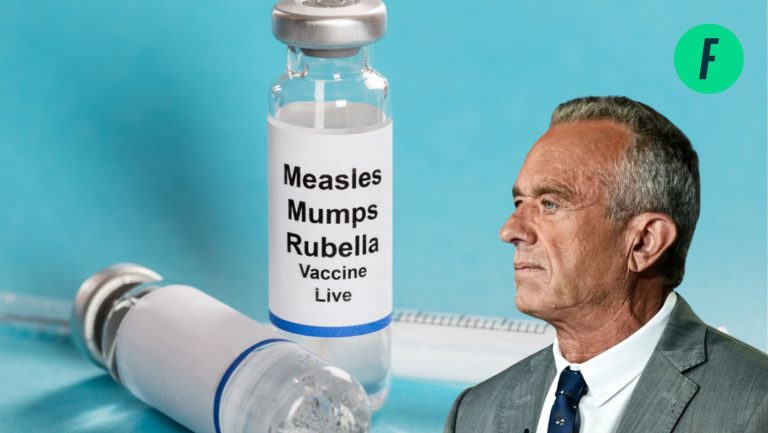

La desinformación generada por I.A. puede tomar muchas formas. La más reconocible es la que se produce en campañas políticas y en periodos electorales. Sin embargo, hay formas de desinformación más habituales (cotidianas) y mucho más dañinas: Remedios para curar la diabetes en redes sociales, que promociona el doctor Ugarte, o anuncios del periodista Daniel Matamala para promocionar la inversión en criptomonedas.

Estos ejemplos existen en la realidad, pero no son reales. ¿Me explico? También hay estudiantes que crean imágenes con I.A. de sus compañeras desnudas y las difunden por WhatsApp, como lo que hicieron los chicos del Saint George. O la creación de fotos de Pinochet y Hitler con políticos actuales, divirtiéndose, de la mano o charlando con gran afán, creadas con Grok, el divertido asistente de X.

¿Es negativo el desarrollo de la IA en la vida pública y privada de las personas? No. El desarrollo tecnológico nos traerá beneficios, sin lugar a dudas, tal y como el Internet y las redes sociales lo hicieron. Pero, esto no significa que debamos mirar hacia el lado cada vez que enfrentamos el lado b de estos avances. La desinformación, en la era de la Inteligencia Artificial necesita de ciudadanos más críticos y con menores brechas tecnológicas para no ser timados por quienes promueven el contenido falso.

En este sentido, en Fast Check CL, creemos que como ciudadanos debemos tener en cuenta al menos tres compromisos fundamentales para mitigar los efectos que puede producir la desinformación potenciada con I.A. en la esfera pública: Cuida tus fuentes, Comparte solo si generas valor, Exige AMI.

Cuando hablamos de cuidar las fuentes hacemos una defensa del periodismo basado en evidencia con contenido de interés público. Hoy cualquiera puede crear contenidos, por ende, pareciera que el periodismo ya no es relevante ni necesario, o así nos quieren hacer creer algunos. Esto no es cierto. En un mundo donde existen muchas fuentes de información de baja calidad, lo mejor es cuidar las buenas fuentes que tengamos que profesionalmente generan contenido de alta calidad. Ayudemos a sostener un ecosistema con buenas fuentes para que la información que consumamos sea la mejor.

¿La imagen creada con I.A. que buscas compartir con alguien más le genera valor? Si no lo genera ¿por qué lo compartirías? Es importante que cuando estemos frente a la disyuntiva de compartir contenido, pensemos en qué valor le estoy dando al otro al compartirlo. Si después de reflexionar, concluyo que no aporto lo suficiente, es mejor no crear/compartir ese contenido. Tus amigos no te necesitan para consumir esos contenidos, seguramente ellos ya los buscan por sí solos, o les llegan a través de otras plataformas.

Un concepto poco conocido, pero que nació hace bastante tiempo atrás, Alfabetización Mediática Informacional (AMI) es un conjunto de habilidades que debe desarrollar un individuo para 1) reconocer sus necesidades informativas; 2) localizar y evaluar la calidad de la información; 3) almacenar y recuperar información; 4) hacer un uso efectivo y ético de la información; 5) aplicar la información a la creación y transmisión de conocimiento. ¿Sabes si en el colegio de tu hijo/a hacen algo de esto? ¿Tuviste algo de esto en el tuyo? Si la respuesta es NO, empieza a exigirlo. Es la única forma de que en el largo plazo los que son hoy estudiantes, no sean atrapados por desinformación y tengan mejores herramientas que nosotros para combatirla.